Financial Close Process und Konsolidierung, Teil 2: Datenintegration und Automatisierung

24.08.2022 | Heimo Teubenbacher Financial Close Process Konsolidierung

Die aktuelle wirtschaftliche Dynamik und die vielfältigen geopolitischen Herausforderungen haben den Fokus für CFOs verschoben: Es gilt die Zukunftsfähigkeit jetzt sicherzustellen. Agilität ist dabei das Gebot der Stunde. Teil 2 wirft ein Schlaglicht auf das Themengebiet „Datenintegration und Automatisierung“, insbesondere auf die Effizienzsteigerung der Ladeprozesse, durch die Vermeidung diverser Bruchstellen. Dahinter steht das Ziel, Daten „auf Knopfdruck“ zur Analyse und Berichtserstellung bereit zu stellen.

Daten Integration schafft Effizienzsteigerung durch Automatisierung!

Die Kernfrage dieses zweiten Teils unserer Blogserie drängt sich aus meiner Sicht geradezu auf: Wieso ist es nach wie vor derart aufwendig, Informationen über die exakte Lage eines Unternehmens zu erhalten? Die einschlägigen Schlagworte, die hierzu fallen, lauten: heterogene IT-Landschaft mit Silos, unterschiedliche Buchungsregimes wie HGB, IFRS oder US-GAAP, variierende Berichtspflichten, fehlendes Bereichsübergreifendes Denken und Agieren.

Begibt man sich nun gedanklich in eine „ideale Welt“, gibt es für dieses Problem nur eine Lösung: „Single Source of Truth“. Aber wie gelingt das, ohne Unsummen für eine „Enterprise Data Warehouse“ auszugeben, um am Ende zu erkennen: das sind nicht die vom Fachbereich gewünschten Informationen bzw. sie lassen sich nicht so einfach zu aussagekräftigen Informationen verdichten. Aus dieser Erkenntnis folgt für mich, dass es darum gehen muss, die einzelnen „Aspekte“, die ein Data Warehouse auszeichnen, separat zu beurteilen. Hierzu gehören:

- Datenmodell: „die“ Voraussetzung für jedes datengetriebene Business

- Datenintegration und Automatisierung: denn Schnittstellen sind unvermeidlich

- Harmonisierung und Validierung von Daten: Master Data Management ist key (egal wie?)

- „tiefe“ Integrationsansätze: Account Reconsiliation und Transactional Matching als Enabler

Nun stellt sich die Frage: Wie passt das alles zum eigentlichen Themengebiet „Financial-Close-Prozess und Konsolidierung“? Und daran anschließend: Welche Rechnungswesen- und Konsolidierungsexperten fühlen sich davon angesprochen?

Vielleicht liegt gerade hier des „Pudels Kern“: Es bedarf einer engen Kooperation zwischen IT und Fachbereich, um gemeinsam eine zukunftstaugliche Lösung zu finden. Das Gleiche gilt für die Zusammenarbeit der Experten aus Accounting, Konsolidierung und Controlling.

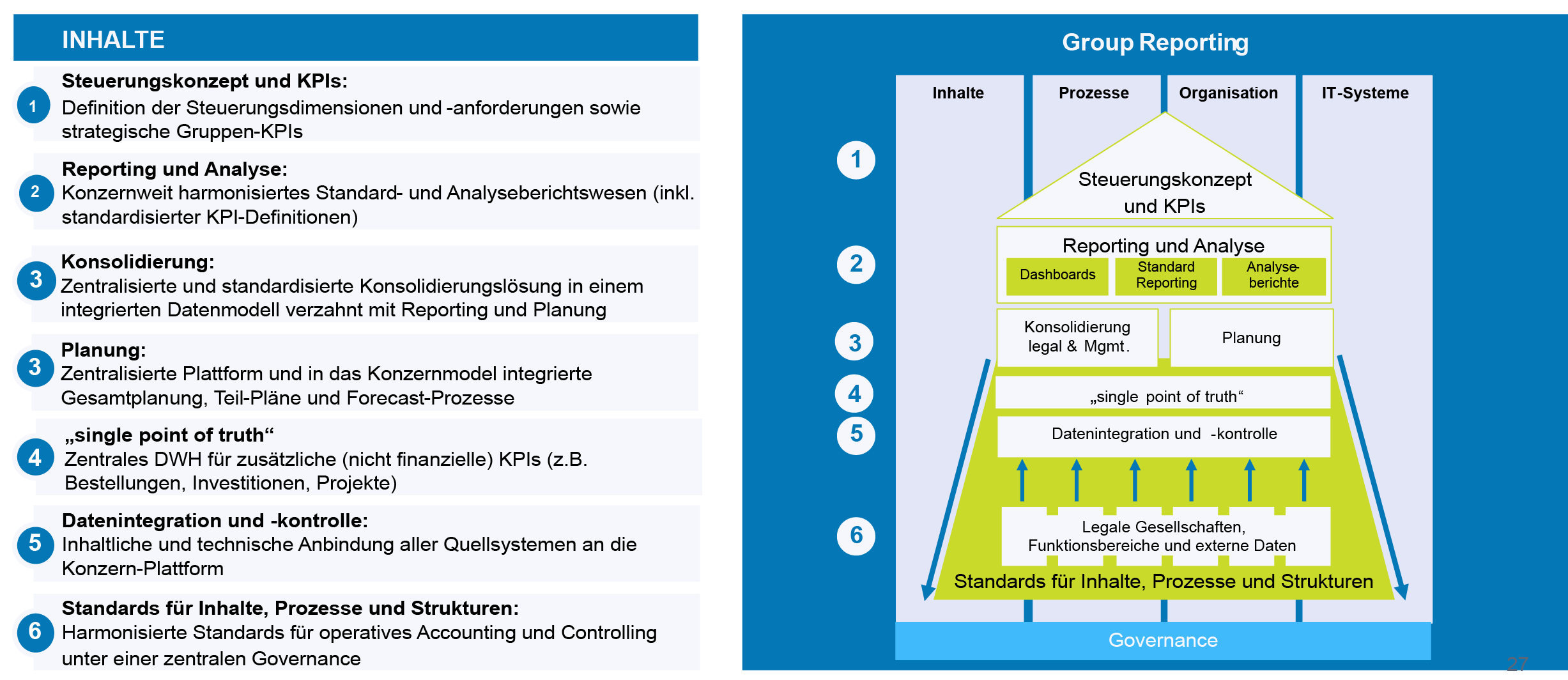

Die Abbildung beschreibt die Themen, die wir im Rahmen unserer Beratung grundsätzlich vorab klären, bevor wir eine Empfehlung für eine konkrete IT-Lösung abgeben. Hierbei gilt es, zuerst das Steuerungskonzept „top down“ zu definieren und die erforderlichen Inhalte zu beschreiben. Anschließend ist zu beurteilen, wer im Unternehmen für die Bereitstellung dieser Daten verantwortlich ist und wie die Prozesse dafür organisiert sind. Im Rahmen eines Projektes werden dann sowohl die „Streams“ (Inhalte, Prozesse, Organisation, IT-Systeme) als auch die „Layer“ (1-6) „durchleuchtet“, um die die Ausgangssituation und Anforderungen für eine mögliche IT-Lösung zu klären.

In meiner Rolle als „Business Development Corporate Performance Management“ - hinter diesem Titel steckt das Themengebiet „Reporting, Konsolidierung und Planung“ - fühle ich mich berufen, die „Brückenfunktion“ einzunehmen und im weiteren Artikel näher auszuführen, wie der Brückenschlag gelingt.

Datenmodell: „die“ Voraussetzung für jede datengetriebene Lösung

Ich bin immer wieder überrascht, wie schwierig es zum Beginn eines Projektes ist, die „richtige“ Datenstruktur zu finden. Allein das Denken in Dimensionen, Hierarchien und Parallelhierarchien sowie in Würfelmodellen und Attributen erfordert eine erhebliche Portion Geduld, um eine „gemeinsame“ Sprache zu finden.

Am Ende stellt sich oftmals heraus, dass sich aus der Berichtssicht - mit der UserInnen vertraut sind - ohnehin die nötigen Informationen ableiten lassen. Doch auch hier kann es oft zu Verwirrung kommen, wenn zu beurteilen ist, wie viele unterschiedliche Berichte existieren: Handelt es sich bereits um einen anderen Bericht, nur weil Spalten und Zeilen getauscht oder ausgewechselt werden oder wenn einzelne Filter aktiviert oder deaktiviert werden? Doch dazu an anderer Stelle mehr, denn zunächst gilt es ohnehin ein „einheitliches“ Datenmodell abzuleiten.

Üblicherweise geben hierbei auch die CPM-Lösungen bereits ein Gerüst vor und Dimensionen wie Zeit, Organisationsstruktur, Währung, Kontenstruktur sind ohnehin zwingend für einen Konsolidierungsprozess erforderlich. Wir sehen jedoch zunehmend, dass sich die „legale Sicht“ mit der Managementsicht kreuzt und weitere Dimensionen hinzukommen, etwa Segmente bzw. Profit- und Cost-Center, Produkte, Kunden und Regionen. Das erhöht zwar die Komplexität und führt zu einer Matrix-Konsolidierung, bringt jedoch den Vorteil, dass unabhängig von der Sicht auf die Daten (Würfelmodell) immer dieselben Aggregate sichergestellt sind. Je nach Steuerungsperspektive bekommt der jeweilige Entscheidungsträger die Informationen dann entsprechend aufbereitet.

Datenintegration und Automatisierung: Schnittstellen sind unvermeidlich

Allein aufgrund der Vielzahl an unterschiedlichen ERP- und FiBU-Quellsystemen ist der Wunsch nach einer integrierten Finanzplattform nachvollziehbar. Doch vor allem in komplexen Konzernstrukturen wird eine Vereinheitlichung aller Quellsysteme sicher nie erreicht oder zumindest nur mit entsprechend hohem finanziellen Aufwand möglich.

Vor diesem Hintergrund ist es jedoch für die Unternehmenssteuerung sowohl aus finanziellen als auch nicht-finanziellen Zielen unerlässlich, eine Datenharmonisierung herzustellen. Hierfür hat sich der Begriff der „single source-of-truth“ etabliert, mit dem gemeint ist, dass alle Berichtsnutzer auf einen qualitätsgesicherten Datenpool zugreifen.

Als Faustregel gilt: Je „tiefer“ diese Integrationsschicht in der IT-Landschaft eingezogen wird, desto größer ist der Automatisierungserfolg. Es hat sich hierbei bewährt, mit entsprechenden Tools die technische Integration „auf Knopfdruck“ sicherzustellen. Das führt mich bereits zu den nächsten Schlagworten:

Im Falle unterschiedlicher Strukturinformationen kann der Einsatz von dedizierten Master-Data-Management-Tools eine sinnvolle Ergänzung darstellen, um am Ende Gleiches tatsächlich gleich zu beurteilen und zu behandeln. Dies ist jedoch eher in einer äußerst heterogenen IT-Landschaft mit unterschiedlichen Verkaufs-Channels oder operationellen Daten erforderlich.

Die Harmonisierung unterschiedlicher Ausprägungen wird traditionell in einem ETL-Prozess (Extract, Transform, Load) vorgenommen und ist durch ein entsprechendes Mapping der lokalen Ausprägungen der einzelnen Elemente auf eine vereinheitlichte Konzernsicht umzusetzen. Erst dadurch ist sichergestellt, dass Daten zu aussagekräftigen Informationen aggregiert werden können.

Nun fehlt noch ein weiteres Schlagwort in diesem Zusammenhang: Validierung. Darunter versteht man in Zusammenhang mit unserem Themengebiet die automationsunterstützte Überprüfung, ob die verarbeiteten Daten den erwarteten Ausprägungen entsprechen. Dies wird durch definierte Regeln sichergestellt. Zum Beispiel kann im Zuge des Ladeprozesses ein Qualitätscheck erfolgen, der prüft, ob die jeweiligen Datenformate der einzelnen Datenfelder richtig befüllt werden, ob gewisse Schwellwerte über- oder unterschritten werden, ob Summen - wie die Bilanzsumme - eine Soll-Haben-Gleichheit aufweisen oder ob die Summe des Anlagevermögens auch so in der Bilanz aufscheint etc.

Fehlermeldungen können hierbei als „blocking error“ dazu veranlassen, den Fehler zu beheben, bevor die Daten geladen werden oder als „warning error“ zumindest eine Kommentierung erforderlich machen - (dies ist im Financial-Close-Prozess eher unüblich, im Planungsprozess jedoch oftmals erwünscht).

Harmonisierung und Validierung von Daten: Master Data Management ist key (egal wie?)

Harmonisierung und Validierung von Daten: Master Data Management ist key (egal wie?)

Im Falle unterschiedlicher Strukturinformationen kann der Einsatz von dedizierten Master-Data-Management-Tools eine sinnvolle Ergänzung darstellen, um am Ende Gleiches tatsächlich gleich zu beurteilen und zu behandeln. Dies ist jedoch eher in einer äußerst heterogenen IT-Landschaft mit unterschiedlichen Verkaufs-Channels oder operationellen Daten erforderlich.

Die Harmonisierung unterschiedlicher Ausprägungen wird traditionell in einem ETL-Prozess (Extract, Transform, Load) vorgenommen und ist durch ein entsprechendes Mapping der lokalen Ausprägungen der einzelnen Elemente auf eine vereinheitlichte Konzernsicht umzusetzen. Erst dadurch ist sichergestellt, dass Daten zu aussagekräftigen Informationen aggregiert werden können.

Nun fehlt noch ein weiteres Schlagwort in diesem Zusammenhang: Validierung. Darunter versteht man in Zusammenhang mit unserem Themengebiet die automationsunterstützte Überprüfung, ob die verarbeiteten Daten den erwarteten Ausprägungen entsprechen. Dies wird durch definierte Regeln sichergestellt. Zum Beispiel kann im Zuge des Ladeprozesses ein Qualitätscheck erfolgen, der prüft, ob die jeweiligen Datenformate der einzelnen Datenfelder richtig befüllt werden, ob gewisse Schwellwerte über- oder unterschritten werden, ob Summen - wie die Bilanzsumme - eine Soll-Haben-Gleichheit aufweisen oder ob die Summe des Anlagevermögens auch so in der Bilanz aufscheint etc.

Fehlermeldungen können hierbei als „blocking error“ dazu veranlassen, den Fehler zu beheben, bevor die Daten geladen werden oder als „warning error“ zumindest eine Kommentierung erforderlich machen - (dies ist im Financial-Close-Prozess eher unüblich, im Planungsprozess jedoch oftmals erwünscht).

"tiefe“ Integrationsansätze: Account Reconsiliation und Transactional Matching als Enabler

Apropos „erwünscht“: mit „tiefe“ Integration bezeichne ich die Möglichkeit, dass bereits einzelne Sub-Ledger innerhalb einer Organisation mit dem Hauptbuch automatisch abgeglichen werden. Hierfür hat sich der Begriff „Account Reconsiliation“ etabliert und es gibt dafür sowohl „Stand-alone-Lösungen“ als auch modulare Erweiterungen von Konsolidierungslösungen. Wer diese „tiefe“ Integration scheut, jedoch in der Konzernzentrale arbeitet, wird mit dem „Transactional Matching“ mehr vertraut sein, denn hier werden die einzelnen Intercompany-Buchungen bereits einem Abgleich unterzogen und Differenzen im Vorfeld der Konsolidierung ausgemerzt. Fast Close, wird dadurch überhaupt erst möglich!

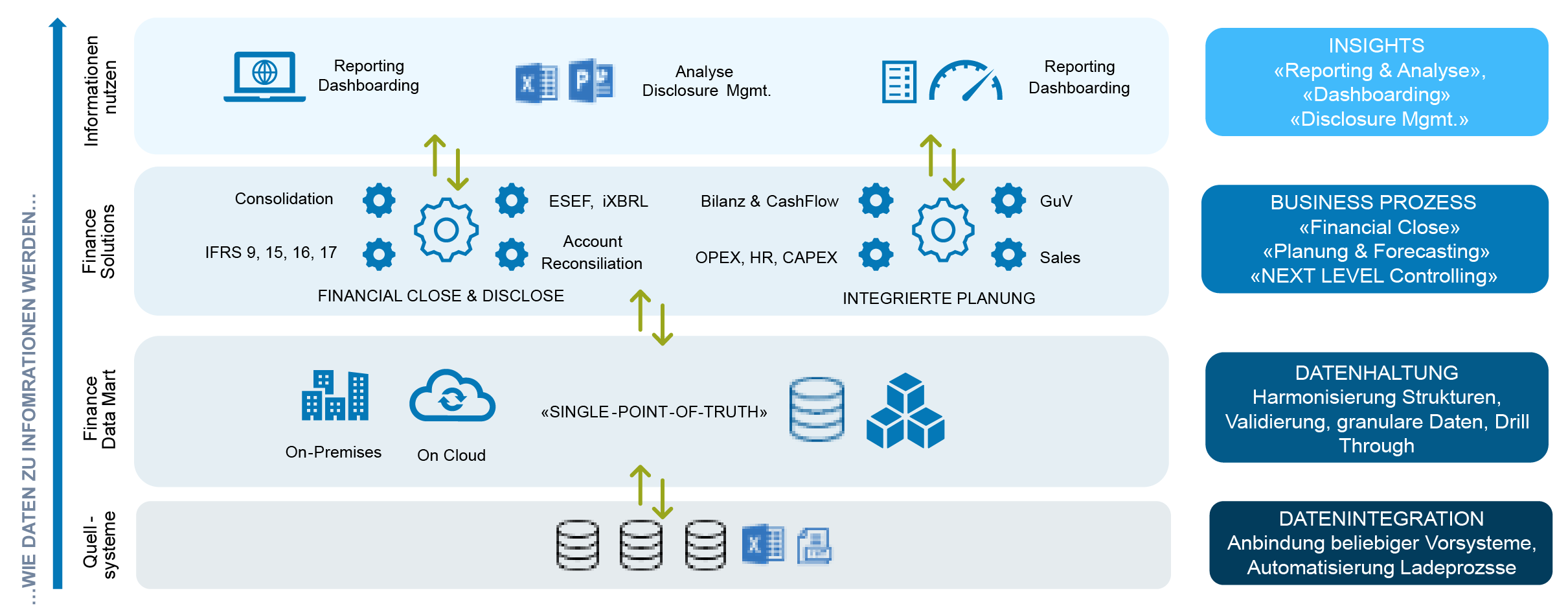

Abschließend möchte ich diesen zweiten Teil mit einem Schaubild, das die Layerstruktur einer integrierten Finanzarchitektur zeigt und bereits auf den dritten Teil dieser Serie verweist. Denn „Insights“- oder auf Deutsch „Einsichten“ - bezieht sich auf die Berichtserstellung, die Analyse sowie auf die „letzte Meile“, nämlich das Disclosure Management, dem sich der nächste und letzte Teil dieser Serie widmet.